Die Digitalisierung hat in den vergangenen Jahren vieles ins Rollen gebracht. Während früher durch Innenstädte geschlendert werden musste, um einen bestimmten Schuh zu finden, reicht heute ein Klick und am nächsten Tag steht der Paketbote vor der Tür. Auch Spielhallen, einst grell beleuchtet und energiehungrig, weichen inzwischen digitalen Plattformen.

Auch auf der Hardwareseite lässt sich viel bewegen. Während herkömmliche Grafikkarten bei KI-Aufgaben enorme Mengen Strom verbrauchen, bieten spezielle Chips wie TPUs oder ASICs deutlich effizientere Alternativen. Zusätzlich hilft es, die Verarbeitung direkt auf Endgeräten durchzuführen, was Rechenzentren entlastet.

Ein Problem bleibt jedoch. Der Energieverbrauch von KI-Modellen ist in der Regel nicht transparent. Es fehlen Standards, wie bei Haushaltsgeräten oder Fahrzeugen. Nutzer erkennen kaum, ob ein System klimafreundlich oder energieintensiv arbeitet.

Einige Open-Source-Communities versuchen, diese Lücke zu schließen. Sie entwickeln kompakte Modelle, die weniger Ressourcen benötigen und trotzdem alltagstauglich bleiben. Doch gegen die dominanten Tech-Giganten wirken diese Projekte bislang eher wie zarte Pflänzchen im Gegenwind.

Auch auf der Hardwareseite lässt sich viel bewegen. Während herkömmliche Grafikkarten bei KI-Aufgaben enorme Mengen Strom verbrauchen, bieten spezielle Chips wie TPUs oder ASICs deutlich effizientere Alternativen. Zusätzlich hilft es, die Verarbeitung direkt auf Endgeräten durchzuführen, was Rechenzentren entlastet.

Ein Problem bleibt jedoch. Der Energieverbrauch von KI-Modellen ist in der Regel nicht transparent. Es fehlen Standards, wie bei Haushaltsgeräten oder Fahrzeugen. Nutzer erkennen kaum, ob ein System klimafreundlich oder energieintensiv arbeitet.

Einige Open-Source-Communities versuchen, diese Lücke zu schließen. Sie entwickeln kompakte Modelle, die weniger Ressourcen benötigen und trotzdem alltagstauglich bleiben. Doch gegen die dominanten Tech-Giganten wirken diese Projekte bislang eher wie zarte Pflänzchen im Gegenwind.

Ganze Abende lassen sich mittlerweile vor dem Smartphone verbringen, ohne jemals das Wohnzimmer zu verlassen. In Sachen CO₂-Ausstoß und Flächennutzung lässt sich das durchaus als kleine Revolution betrachten. Doch mitten in diesem digitalen Fortschritt schiebt sich eine neue Größe ins Rampenlicht: die künstliche Intelligenz.Vieles spricht dafür, dass sie Prozesse verschlankt, Arbeitszeit spart und sogar den Energieverbrauch senken kann. Doch mit dem Auftritt großer Sprachmodelle wie GPT-3 oder Bildgeneratoren häufen sich die kritischen Stimmen. Es stellt sich eine unbequeme Frage: Wie hoch ist der Energiebedarf dieser Technik wirklich? Und lässt sich dieser Aufwand überhaupt rechtfertigen?

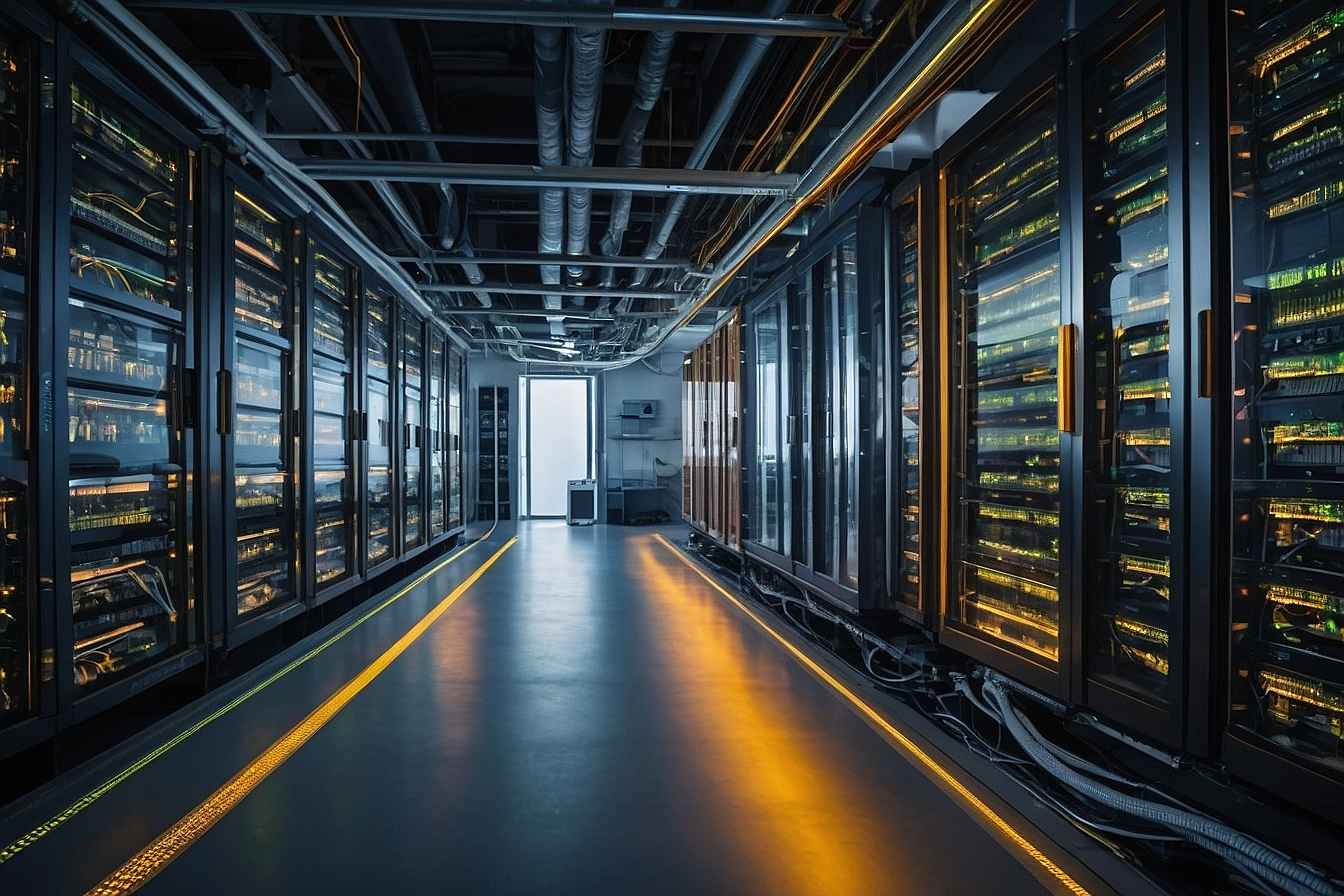

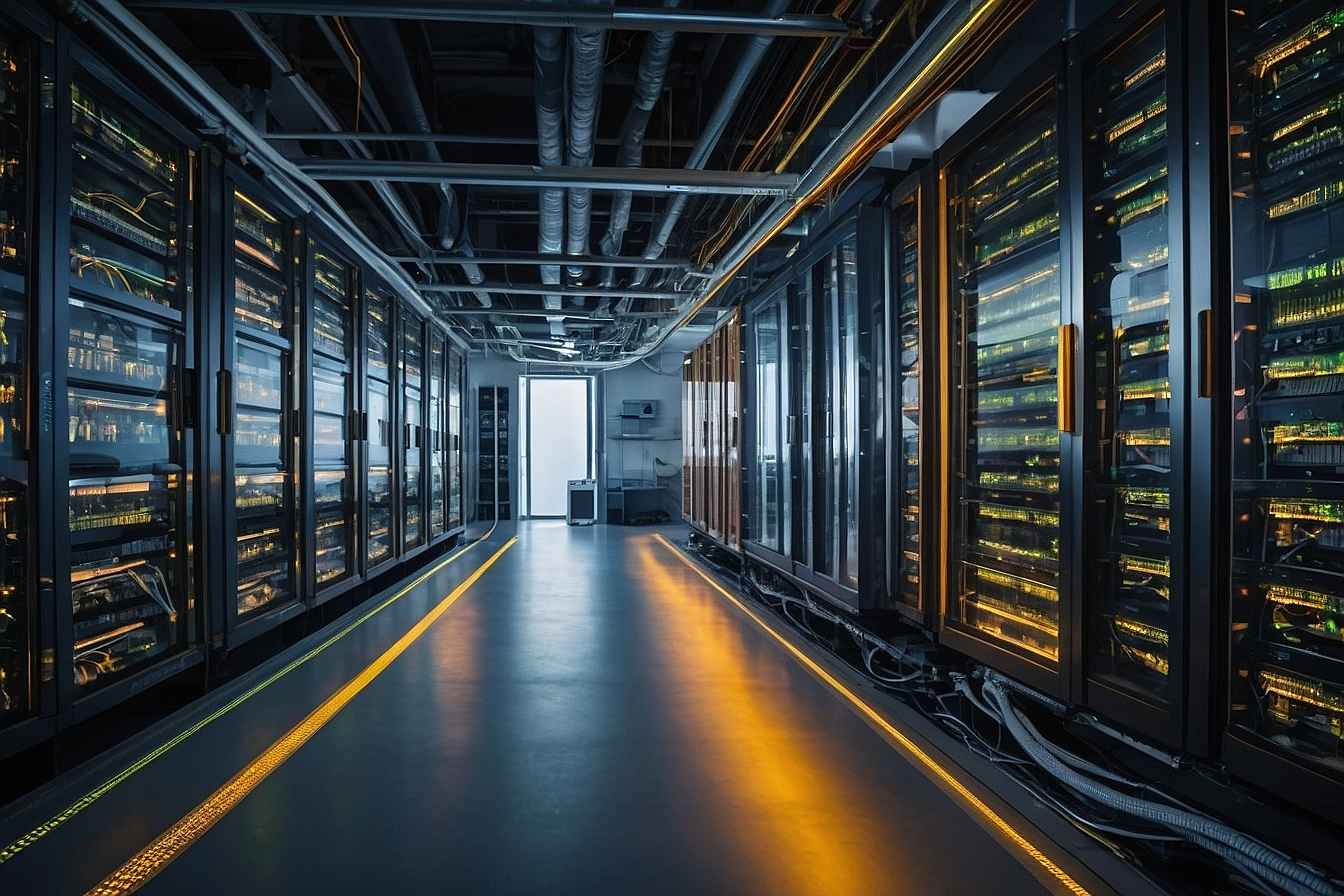

Was beim Training im Maschinenraum passiert und wie KI ganze Kraftwerke beansprucht

Das Training großer KI-Modelle gleicht keinem gemütlichen Rechenvorgang, sondern ähnelt eher einem industriellen Kraftakt. Wenn ein Sprachmodell wie GPT seinen Lernprozess durchläuft, wird dieser nicht von einem einzelnen Rechner gestemmt. Stattdessen teilen sich tausende Hochleistungsprozessoren die Arbeit, sie laufen parallel, rund um die Uhr und über viele Wochen hinweg. Dabei geht es nicht bloß um das Verstehen von Text, sondern um die Optimierung eines neuronalen Netzes mit Milliarden Parametern. Immer wieder durchlaufen die Daten das System, während der Stromzähler im Rechenzentrum mit atemberaubender Geschwindigkeit rotiert.Beim Training von GPT-3 lag der Energieverbrauch bei mehreren hundert Megawattstunden. Daraus resultierte ein CO₂-Ausstoß, der dem jährlichen Fußabdruck von mehr als hundert deutschen Haushalten entsprach. Vergleiche mit Flugreisen drängen sich auf, mehrere Dutzend Interkontinentalflüge ergeben eine ähnliche Bilanz.Doch nicht nur Strom wird benötigt. Um die glühenden Maschinen auf Betriebstemperatur zu halten, fließt zusätzlich eine gewaltige Menge Wasser durch die Kühlanlagen. Beim Training eines einzigen Modells können mehrere Hunderttausend Liter erforderlich werden. Besonders brisant ist der Zusammenhang zwischen Modellgröße und Energieaufwand. Verdoppeln sich die Parameter, steigt der Verbrauch nicht linear, sondern vervielfacht sich. Mehr Leistung bedeutet also nicht nur mehr Können, sondern auch einen überproportionalen Hunger nach Ressourcen.

Wenn Algorithmen nicht abschalten und der Dauerbetrieb zur Belastung wird

Nach dem Training beginnt der Alltag. Denn ein KI-Modell legt sich nicht zurück, sobald es einmal programmiert wurde. Im Gegenteil, die eigentliche Arbeit beginnt erst jetzt. Jede Textausgabe, jede Bilderstellung, jede Sprachantwort verbraucht erneut Energie. Zwar ist der Aufwand pro Anfrage vergleichsweise gering, doch bei Milliarden Anfragen pro Tag entsteht ein beachtlicher Gesamtverbrauch.Sprachassistenten auf dem Smartphone, automatische Übersetzungen im Browser oder personalisierte Produktempfehlungen – sie alle greifen im Hintergrund auf zentrale Rechenzentren zu. Diese wiederum laufen dauerhaft und verlangen konstanten Energieeinsatz.Viele dieser Anwendungen wirken auf den ersten Blick unscheinbar. Doch in ihrer Summe entfaltet sich ein erheblicher Energiebedarf, der sich wie ein unsichtbares Netz durch den Alltag zieht. Denn auch wenn jede Anfrage einzeln kaum ins Gewicht fällt, ergibt sich durch die globale Verbreitung ein Effekt, der kaum mehr zu übersehen ist.

Digitalisierung bringt Entlastung – doch wie viel davon lässt sich der KI zuschreiben?

Rückblickend lässt sich feststellen, dass digitale Prozesse eine ganze Reihe klimafreundlicher Effekte angestoßen haben. Der Onlinehandel macht zahlreiche stationäre Geschäfte überflüssig. Digitale Kommunikation ersetzt Geschäftsreisen. Und in vielen Bereichen entstehen durch Digitalisierung messbare Effizienzgewinne. So ist etwa in der Glücksspielbranche ein Wandel zu beobachten. Wo einst zahlreiche Spielhallen mit hohem Energiebedarf betrieben wurden, genügt heute eine App und ein Internetzugang, um Eye of Horus zu spielen. Die benötigte Fläche sinkt, der Stromverbrauch und die Emissionen gehen ebenfalls zurück. Ein ähnliches Bild zeigt sich im Einzelhandel, wo durch Zentralisierung und automatisierte Logistik der ökologische Fußabdruck kleiner wird.KI verstärkt diese Effekte, indem sie Prozesse noch intelligenter steuert. In der Industrie hilft sie, Maschinen besser auszulasten. In der Energiebranche sorgt sie für eine präzisere Netzauslastung. Und bei der Verkehrssteuerung ermöglicht sie dynamische Anpassungen, die Staus vermeiden und Treibstoff sparen.Allerdings bleibt offen, ob die positiven Effekte in der Praxis groß genug sind, um den eigenen Energiebedarf zu übertreffen. Während einzelne Erfolgsgeschichten existieren, fehlt bislang eine umfassende Bilanz. Klar ist nur: Die Richtung stimmt – doch das Tempo reicht noch nicht aus.

Technologischer Fortschritt genügt nicht, wenn er den Verbrauch anheizt

Es liegt nahe zu glauben, dass eine bessere Technik automatisch zu mehr Nachhaltigkeit führt. In der Realität sieht das jedoch oft anders aus. Sobald eine Anwendung effizienter und günstiger wird, steigt in vielen Fällen ihre Nutzung. Dieses Phänomen ist nicht neu. Schon im 19. Jahrhundert erkannte William Jevons, dass effizientere Kohlekraftwerke nicht weniger, sondern mehr Kohle verbrauchten. Genau dieser Mechanismus lässt sich heute bei KI beobachten. Je leistungsfähiger die Modelle, desto mehr werden sie genutzt. Bildgeneratoren, die binnen Sekunden hochwertige Ergebnisse liefern, sorgen dafür, dass Inhalte massenhaft und ohne großen Aufwand produziert werden. Die gesparte Zeit wird nicht etwa eingespart, sondern für noch mehr Aufgaben eingesetzt.Auch im Bereich Online-Werbung, Textproduktion oder Musikempfehlung lässt sich dieses Muster beobachten. Die Technik wird besser, billiger und bequemer, dadurch steigt ihr Verbrauch.Solange diese Entwicklung ohne Grenzen verläuft, entsteht trotz Effizienzsteigerung ein wachsender Energiebedarf. Die eigentliche Herausforderung besteht daher nicht in der technischen Verbesserung, sondern in der bewussten Steuerung des Einsatzes.

Grüne KI als Ziel und notwendiger Entwicklungspfad

Die Idee einer ressourcenschonenden Künstlichen Intelligenz hat bereits ein konkretes Etikett: Green AI. Dieser Ansatz beschreibt nicht nur eine technische Option, sondern eine Notwendigkeit für die Zukunft. Ziel ist es, Systeme zu entwickeln, die nur so viel Rechenleistung wie nötig benötigen. Statt gigantische Modelle ständig neu zu trainieren, könnten kleinere, spezialisierte Varianten ausreichen. Techniken wie Transfer Learning oder sparsames Fine-Tuning zeigen, dass weniger oft mehr sein kann. Auch auf der Hardwareseite lässt sich viel bewegen. Während herkömmliche Grafikkarten bei KI-Aufgaben enorme Mengen Strom verbrauchen, bieten spezielle Chips wie TPUs oder ASICs deutlich effizientere Alternativen. Zusätzlich hilft es, die Verarbeitung direkt auf Endgeräten durchzuführen, was Rechenzentren entlastet.

Ein Problem bleibt jedoch. Der Energieverbrauch von KI-Modellen ist in der Regel nicht transparent. Es fehlen Standards, wie bei Haushaltsgeräten oder Fahrzeugen. Nutzer erkennen kaum, ob ein System klimafreundlich oder energieintensiv arbeitet.

Einige Open-Source-Communities versuchen, diese Lücke zu schließen. Sie entwickeln kompakte Modelle, die weniger Ressourcen benötigen und trotzdem alltagstauglich bleiben. Doch gegen die dominanten Tech-Giganten wirken diese Projekte bislang eher wie zarte Pflänzchen im Gegenwind.

Auch auf der Hardwareseite lässt sich viel bewegen. Während herkömmliche Grafikkarten bei KI-Aufgaben enorme Mengen Strom verbrauchen, bieten spezielle Chips wie TPUs oder ASICs deutlich effizientere Alternativen. Zusätzlich hilft es, die Verarbeitung direkt auf Endgeräten durchzuführen, was Rechenzentren entlastet.

Ein Problem bleibt jedoch. Der Energieverbrauch von KI-Modellen ist in der Regel nicht transparent. Es fehlen Standards, wie bei Haushaltsgeräten oder Fahrzeugen. Nutzer erkennen kaum, ob ein System klimafreundlich oder energieintensiv arbeitet.

Einige Open-Source-Communities versuchen, diese Lücke zu schließen. Sie entwickeln kompakte Modelle, die weniger Ressourcen benötigen und trotzdem alltagstauglich bleiben. Doch gegen die dominanten Tech-Giganten wirken diese Projekte bislang eher wie zarte Pflänzchen im Gegenwind.

Rechenzentren stehen unter Druck, klimafreundlicher zu werden

Im Zentrum des KI-Betriebs stehen Rechenzentren, Gebäude, in denen tausende Server rund um die Uhr arbeiten. Ihr Strombedarf ist immens, ihre Bedeutung ebenso. Ohne sie keine KI, keine Cloud, keine Datenverarbeitung. Viele dieser Zentren befinden sich in Ländern mit günstigen Strompreisen. Das bedeutet jedoch nicht automatisch einen klimafreundlichen Betrieb. In manchen Regionen stammen große Teile der Energie weiterhin aus fossilen Quellen.Allerdings gibt es Fortschritte. Einige Betreiber nutzen bereits die entstehende Abwärme für Nahwärmenetze oder andere industrielle Prozesse.Andere setzen auf Solar- oder Windstrom, verbessern ihre Kühltechnik oder verlagern Rechenleistung näher an den Nutzer, um die Übertragungsverluste zu verringern. In Deutschland wird gefordert, dass Rechenzentren bis 2027 klimaneutral betrieben werden. Wie realistisch das ist, hängt von Infrastruktur, Gesetzgebung und Investitionsbereitschaft ab. In anderen Ländern wird die Diskussion weiter gefasst. In den Vereinigten Staaten etwa gibt es erste Überlegungen, eigene Atomkraftwerke zur Versorgung von KI-Infrastruktur zu nutzen. Solche Vorschläge zeigen, wie groß der Energiehunger bereits geworden ist und wie komplex die Suche nach Lösungen sein kann. Global fehlt bisher eine einheitliche Linie. Unternehmen, die an hohe Umweltstandards gebunden sind, könnten sich einen Wettbewerbsnachteil einhandeln, wenn andere ihre Rechenzentren in weniger regulierten Regionen betreiben.

Die Bilanz bleibt offen – KI ist Werkzeug, nicht Lösung

Künstliche Intelligenz besitzt zweifellos das Potenzial, Effizienzgewinne in zahlreichen Bereichen zu erzielen. Von smarter Verkehrssteuerung über vorausschauende Wartung bis zur verbesserten Energieverteilung lassen sich viele dieser Anwendungen dazu nutzen, Emissionen zu senken und Ressourcen zu schonen. Gleichzeitig steht dem ein Energiebedarf gegenüber, der nicht zu unterschätzen ist. Die Infrastruktur ist teuer, die Nutzung ist oft inflationär und der technologische Wettlauf fördert Systeme, deren Nutzen für das Klima bislang unbewiesen ist. Die größten Energiefresser in Bezug auf Ki lassen sich wie folgt zusammenfassen:- Training großer Sprachmodelle

- Text-zu-Bild-Generatoren

- Multimodale KI-Systeme

- GPU- und TPU-Cluster

- Wassergekühlte Rechenzentren

- Inferenz im Massenbetrieb

- Echtzeitverarbeitung (z. B. Autonomes Fahren)

- KI-gestützte Videoüberwachung

- Personalisierung von Inhalten

- Wissenschaftliche Simulationen

- Generative Textproduktion

- Kontinuierliches Feintuning

- Globale Synchronisierung verteilter Systeme